DeepSeek‘in MIT lisansı ile yayınlanan V3 sürümü DeepSeek-V3-0324’ü sizlerle paylaşmıştık. Ağustos ayında şirketin ajan çağı için ilk adımı olarak tanımlanan DeepSeek V3.1‘i tanıtan Çin merkezli şirket, yalnızca birkaç gün önce, bir önceki sürüme kıyasla benchmark testlerinde daha istikrarlı ve güvenilir sonuçlar sunan DeepSeek-V3.1-Terminus ile gündeme geldi. Şirket şimdi de DeepSeek-V3.2-Exp adlı deneysel modeli ile karşımızda. DeepSeek’in belirttiğine göre; DeepSeek-V3.2-Exp, önceki V3.1-Terminus modeliyle neredeyse aynı çıktı kalitesini korurken, uzun metinleri çok daha verimli bir şekilde işliyor.

Paylaşılan bilgilere göre bu deneysel sürüm, V3.1-Terminus modelini temel alarak DeepSeek Sparse Attention (DSA) teknolojisini sunuyor. Seyrek dikkat teknolojisi olarak tanımlayabileceğimiz DSA’nın, uzun bağlamlarda eğitim ve çıkarımları önemli ölçüde iyileştirmesi bekleniyor.

Seyrek dikkat mekanizması, uzun metinlerin yalnızca ilgili kısımlarını işleme için seçiyor. Böylece bu yöntem, gereken hesaplama gücünü önemli ölçüde azaltıyor. Burada geleneksel dikkat mekanizmalarından da bahsetmekte fayda var. Geleneksel dikkat mekanizmaları, her kelimeyi diğer tüm kelimelerle ilişkili olarak değerlendiriyor. Bu nedenle, uzun metinler için katlanarak artan hesaplama gücü gerekiyor. Geliştiriciler DeepSeek’in seyrek dikkat mekanizması sayesinde kapsamlı belgeler için daha hızlı eğitim ve daha ucuz çıkarım elde edebilir.

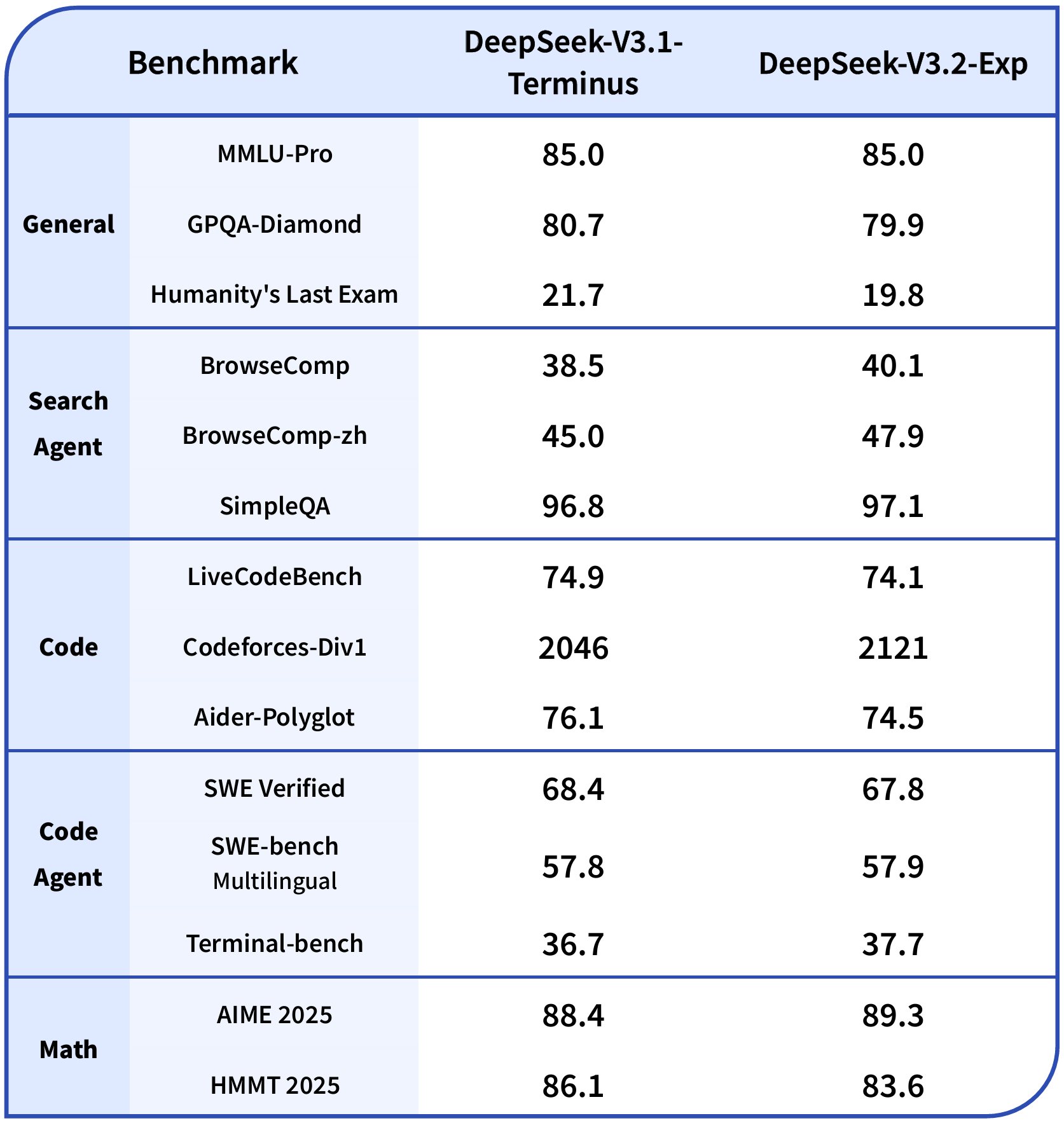

DeepSeek, V3.2-Exp’yi önceki V3.1-Terminus modeliyle kapsamlı bir şekilde kıyaslıyor. MMLU-Pro gibi ölçütlerde, her iki modelin de 85,0 puanla aynı skoru alması dikkat çekiyor. Codeforces gibi programlama ölçütlerinde, V3.2-Exp’in 2121 puanla V3.1-Terminus’un 2046 puanına kıyasla biraz daha iyi performans gösterdiğini belirtelimç Şirket, adil bir karşılaştırma yapabilmek için kasıtlı olarak aynı eğitim yapılandırmalarını kullandığını belirtiyor.

V3.2-Exp modeli, ticari ve akademik kullanıma izin veren bir MIT lisansı altında çalışıyor. Model, çeşitli platformlar aracılığıyla geliştiriciler tarafından kullanılabiliyor. HuggingFace modele erişim sağlarken, vLLM destek sunuyor. Model, Nvidia H200’den AMD yongalarına kadar çeşitli donanım yapılandırmalarında çalışıyor. DeepSeek, modeli yerel olarak çalıştırmak isteyen geliştiriciler için çıkarım kodunu da kullanıma sundu. Bununla beraber HuggingFace model ağırlıklarından yerel kullanıma dönüştürme sürecinin, GPU yapılandırması ve uzman ayarları için bazı düzenlemeler gerektirdiğini belirtelim.

Kaynak: webrazzi