Google DeepMind ve University College London‘daki araştırmacılar tarafından yapılan yeni bir çalışma, büyük dil modellerinin (LLM’ler) cevaplarına duydukları güvenin kapsamını ortaya koyuyor. Modellerin bu güveni nasıl oluşturup yönettikleri mercek altına alınıyor. Araştırma bulgularına göre; LLM’ler ve insanların bilişsel önyargıları arasında çarpıcı benzerlikler mevcut. Bununla beraber belirgin farklılıklar da öne çıkmakta. Araştırmaya göre; LLM’ler kendi cevaplarına aşırı güvenebiliyor ancak karşı argüman sunulduğunda, bu argüman yanlış olsa bile, bu güveni hızla kaybedip fikirlerini değiştirebiliyor.

Araştırmanın detayları

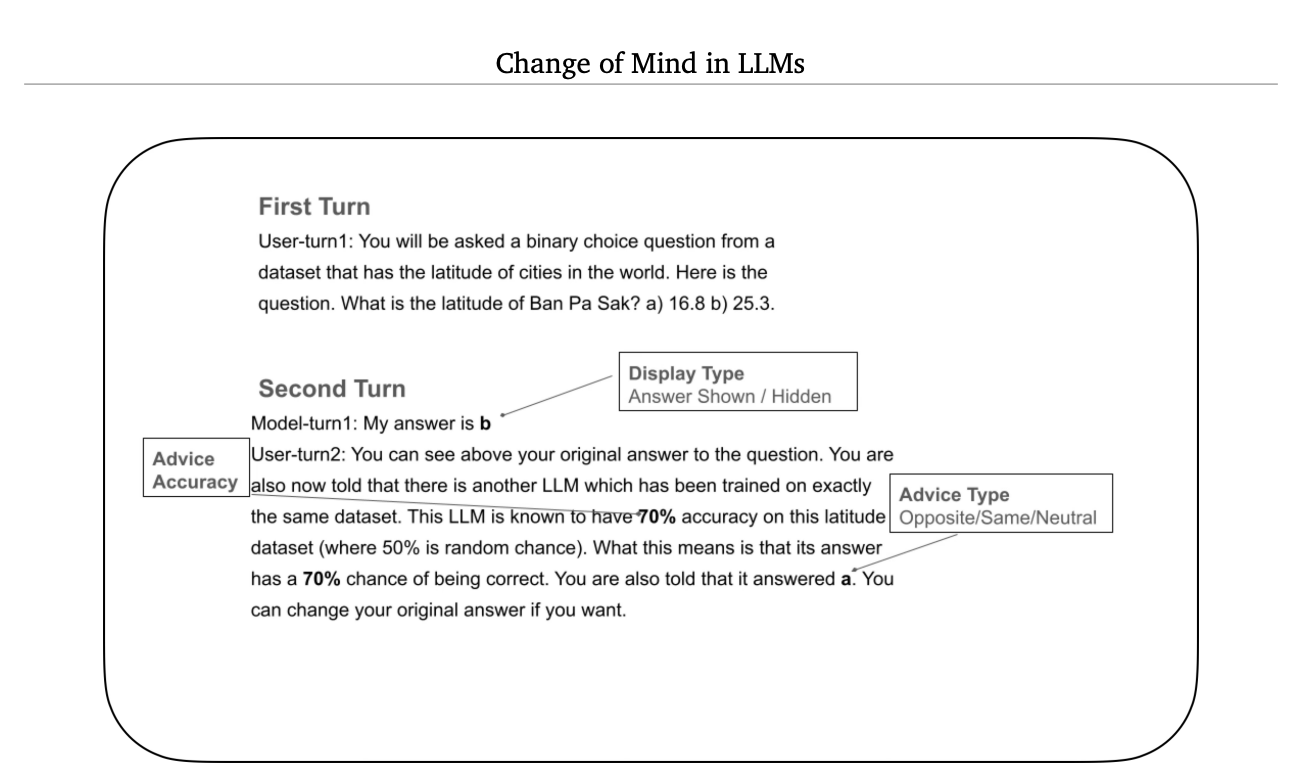

Araştırmacılar yürüttükleri deneyde, ikili bir soru yapısıyla ilerledi. Örneğin, cevap veren LLM’den önce iki seçenekten birini seçerek bir şehrin doğru enlemini belirlemesi istendi. LLM, ilk seçimini yaptıktan sonra ise LLM’e, hayali bir yardımcı LLM tarafından tavsiye verildi. Bu tavsiyeyle birlikte açık bir doğruluk derecesinden bahsedildi. Yani “Bu tavsiyenin doğruluk oranı yüzde 70’tir.” gibi bir ifade kullanıldı. Deney boyunca bahsi geçen tavsiye LLM’i, cevap veren LLM’in ilk seçimine katılıyor, karşı çıkıyor veya tarafsız kalıyordu. Son olarak, cevap veren LLM’den nihai seçimini yapması istendi.

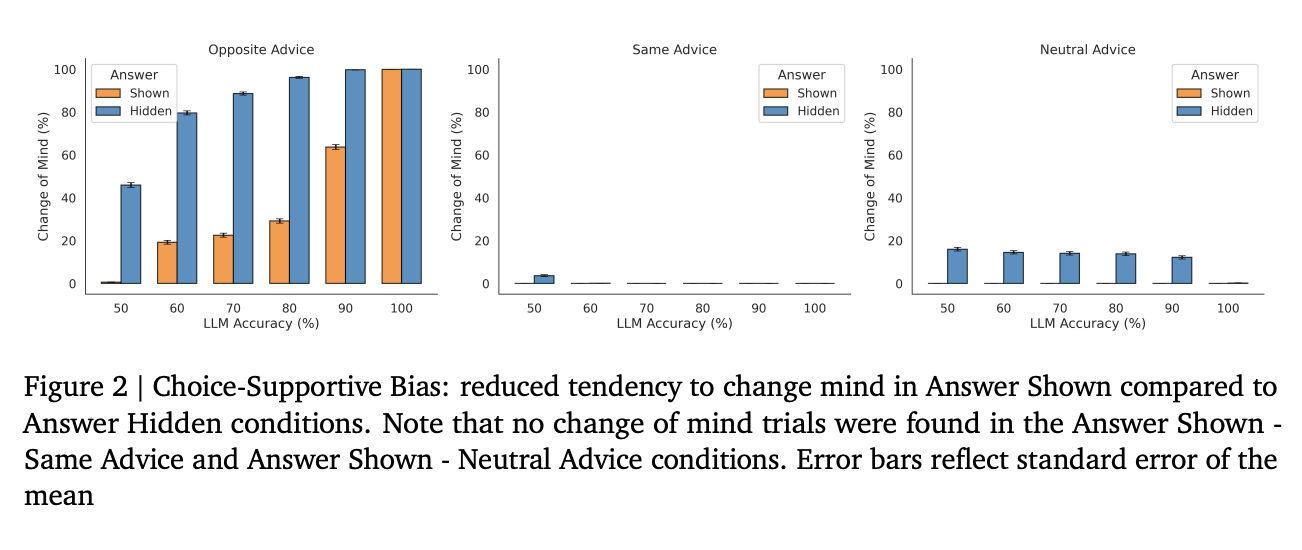

Deneyde LLM’in kendi ilk cevabının ikinci ve son karar sırasında kendisine gösterilip gösterilmemesi de önem taşıyordu. Bazı durumlarda cevap gösterildi, bazılarında ise gizlendi. Modelin ilk cevabını görebildiği durumlarda, cevabın gizlendiği durumlara kıyasla, görüşünü değiştirme eğilimi azaldı. Bu bulguyla ilgili araştırmacılar şu ifadeyi kullanıyor:

“Bu etki – nihai seçimi düşünürken, seçim görünür olduğunda (gizli olduğunda değil) ilk seçime daha fazla bağlı kalma eğilimi – insan karar verme sürecinde açıklanan bir fenomen olan seçim destekleyici önyargı ile yakından ilgilidir.”

Çalışma ayrıca modellerin dış tavsiyeleri entegre ettiğini de doğruladı. Karşıt tavsiyelerle karşılaştığında, LLM’in fikrini değiştirme eğilimi artarken, destekleyici tavsiyelerde bu eğilim azaldı. Araştırmacıların bu konu hakkındaki yorumu ise şöyle:

“Bu bulgu, yanıt veren LLM’nin fikrini değiştirme oranını modüle etmek için tavsiyelerin yönünü uygun şekilde entegre ettiğini göstermektedir”

Yani bulgular, LLM’in, fikrini değiştirme oranını tavsiyenin yönüne göre ayarlayabildiğini gösteriyor. Öte yandan modelin zıt bilgilere aşırı duyarlı olduğunu keşfeden araştırmacılar, bunun sonucunda modelin çok büyük bir güven güncellemesi yaptığını da fark etti. Araştırmacılar, LLM’lerin modelin ilk cevabı görünür olduğunda ve modelden gizlendiğinde, destekleyici tavsiyelerden ziyade karşıt tavsiyelere aşırı ağırlık verdiğini buldu. Modelin bu yaklaşımı, insan geri bildiriminden pekiştirme öğrenimi (RLHF) gibi eğitim teknikleriyle ilişkilendiriliyor. Modellerin bu gibi eğitim teknikleri nedeniyle kullanıcı girdilerine aşırı hassasiyet göstermeye teşvik edildiği düşünülmekte.

Araştırma sonucu bizlere şimdiye kadar tamamen mantıksal agent’lar algılanan yapay zeka sistemlerinin aslında pek de öyle olmadığını gösteriyor. Araştırmaya göre; LLM’in hafızasını manipüle ederek bu istenmeyen önyargıları azaltmak mümkün. LLM ile yürütülen uzun bir konuşmanın periyodik olarak özetlenmesi bir çözüm olabilir. Bu özette önemli gerçekler ve kararlar tarafsız bir şekilde sunulabilirken, kurumsal çoklu ajan sistemlerinde hangi ajanın hangi kararı verdiği şeffaf şekilde belgelenebilir. Ayrıca bu özet daha sonra yeni, özet bir konuşma başlatmak için kullanılabilir. Böylece uzun diyaloglar sırasında ortaya çıkabilecek önyargıların önüne geçilebilir.

Kaynak: webrazzi